技術コラム IoT・AIで変わる

IoT・AIで変わる

「送る&運ぶ」

さまざまな産業において始まりつつある、IoT化、AI(人工知能)活用。

移送・搬送の現場への影響や技術トレンドについて、電子・機械系雑誌のジャーナリストであるエンライト代表:伊藤元昭氏がわかりやすく解説します。

第5回 AIの「ブラックボックス問題」との付き合い方

ここまで、人工知能(AI)の利用シーンや活用メリット、円滑な導入方法についてお話ししてきました。AIを効果的に活用すれば、熟練技術者の勘や知恵に頼っていた高度な作業や判断を自動化し、工場での生産活動や倉庫などの移送・搬送の劇的な高効率化を期待できます。

ただし、AIは万能ではありません。そこで今回は、現在のAIが抱えている技術的課題と、その付き合い方について考えてみたいと思います。(図1)

出典:Adobe Stock/Gorodenkoff

AIの判断は正確無比、ただし理由は語らない

現状のAIの特徴を熟知するエンジニアに言わせれば、「現在のAIは、よく当たる占いのようなもの」なのだそうです。確かに、AIの判断は極めて正確ですが、その根拠は一切わかりません。

第3回で解説したように、これまでのコンピュータは、処理手順をキッチリと定義したプログラム、いわば人間が作った“作業マニュアル”に従って判断していました。このため、判断に至った筋道をさかのぼれば、その根拠を知ることができました。

一方現在のAIは、「機械学習」と呼ばれる技術で、用意された大量のデータを自律的に学習し、判断力を磨いていきます。この技術の重要な点は、人間がマニュアルを与えるのではなく、AIが自ら判断基準を悟り、獲得するということです。つまり、AIが何を学びとったのかは、人間のコントロール下にないのです。AIの判断の根拠が分からないのはこのためです。

一方現在のAIは、「機械学習」と呼ばれる技術で、用意された大量のデータを自律的に学習し、判断力を磨いていきます。この技術の重要な点は、人間がマニュアルを与えるのではなく、AIが自ら判断基準を悟り、獲得するということです。つまり、AIが何を学びとったのかは、人間のコントロール下にないのです。AIの判断の根拠が分からないのはこのためです。

AIのこうした性質は、「ブラックボックス問題」と呼ばれる課題になっています。そして、判断の根拠が分からないと、様々な不都合が生じる可能性があります。

現在のAIには任せない方がよい仕事とは

私たちは、医師や弁護士など権威のある専門家からアドバイスをもらうとき、その根拠を理解していなくても、疑問に思うことなく信じがちです。人間よりも正確な判断を下す現代のAIに対しては、なおさらかもしれません。

しかし、AIの判断結果を鵜呑みにできない応用分野が多くあります。その典型例が自動運転車です。

自動運転車では、カメラの画像や多くのセンサーから集めたデータをAIが解析して、走行環境の状況を把握します。今ではAIによる画像認識は人間を凌駕するレベルに達しており、自動運転技術が進歩すれば、人間が運転するよりも交通事故が減ると言われています。

そんなAIでも事故を起こす可能性はあります。しかしAIが事故を起こした、またはもらい事故に巻き込まれた場合、その原因を突き止めることがむずかしいのが現状です。AIは機械学習によって成長していきますから、想定外の場面で100%正しい判断を下せるとは限りません。しかも判断の根拠を語らないので、人間には事故が起きたという結果以上のことは分かりません。そのような状態では、その判断を鵜呑みにし、人命を預かる仕事をさせるわけにはいかないのです。もしAIが正しく判断しても事故に巻き込まれてしまった場合(図2)、自動車メーカーが事故の賠償責任を負わざるを得なくなる可能性もあります。これでは、自動運転車のビジネスはとても成り立ちません。

出典:Adobe Stock/BlueBeans

また、自動運転技術を進歩させるためには、AIの判断に誤りがあれば、誤りを起こした理由を探り出して改善する必要があります。しかし、AIの判断の根拠が分からなければ、改善の方向性を定めることができません。

AIのブラックボックス問題は、自動運転車に限らず、安全第一で、現場のカイゼン活動を何より大切にする生産現場でも、極めて不都合な性質だと言えます。現在のAIには、人の命や財産に関わる仕事を丸投げしない方がよいことは明らかです。また、AIが下した判断結果をもとにして人間がさらなるカイゼンを加える場合には、判断の根拠を類推するための何らかの手段を併用する必要があることが分かります。

AIの判断の根拠を探る新たな技術

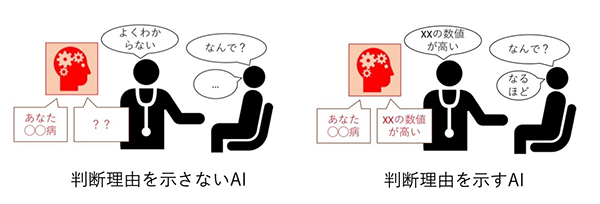

AIのブラックボックス問題を解決するため、「説明可能なAI(Explainable AI:XAI)」と呼ばれるAIが下した判断の根拠を探る技術の開発が進められています(図3)。既に、製造向けのAIシステムの構築を支援するシステム・ベンダーの中には、XAIを提供するところも出てきています。XAIの方法には、大きく二つのアプローチがあります。

出典:総務省の公開資料、大阪大学 産業科学研究所 原 聡氏「「AIの説明」の現状とこれから」

一つは、AIが答えを導き出す際の注目点を特定するアプローチです。例えば、AIの画像認識に適用する際には、まず認識対象となる画像の一部分だけを切り取り、認識処理させます。そして、この作業を繰り返し、画像全体を認識した場合の答えとどの程度変わるのか検証するのです。これにより、判断の対象となるデータの中の、どの部分のどのような特徴に注目して予測・認識したのか明示できるようになります。

もう一つのアプローチは、AIが行う仕事を細分化し、人間が理解しやすいかたちにする方法です。例えば、プラントを動かすポンプの振動から故障の予兆を察知するAIを作ったとします。現在の技術ならば、振動データから故障の兆しを直接察知するAIも作れますが、これでは判断プロセスがブラックボックス化します。そこで、あえてAIの機能を二つに分解します。最初のAIでは、振動データの中から普段とは違う挙動を抜き出します。そして、次のAIで異常挙動とされたデータを解析し、故障に至るか否かを判断します。こうした2段階での解析を行うAIシステムならば、異常を示すデータを知ることができるため、AIの判断理由を探りやすくなります。

前回、大量の写真を学習させて「犬」と「狼」を高精度で見分けられるようになったAIが、実は背景に雪があるかどうかを参考にして見分けていたというAIの困った事例を紹介しました。こうした、学習させればさせるほど想定外の間違いが発生しやすくなる問題は「過学習」と呼ばれています。XAIによって、AIの判断理由を知るヒントが得られれば、こうした過学習を防ぎ、より高精度のAIを育成するためにも使えます。

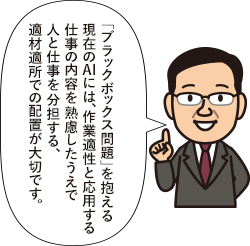

人とAIの適材適所での配置が大切

AIには、人を圧倒するほど得意な仕事があります。画像認識や膨大な数値データの裏側に隠された傾向や法則を見つけ出すことです。経験に裏打ちされた将来起こることを予測する能力や場の空気を読む能力も、おそらくAIの方が優れています。AIは、工場の生産ラインなどのパフォーマンスを格段に高める強力な技術です。ただし、人とAIそれぞれの作業適性と応用する仕事の内容を熟慮したうえで、適材適所を見定めて配置することが活用の成功に向けた条件になります。

まとめ

AIが持つ「判断の根拠が分からない」という性質は「ブラックボックス問題」と呼ばれ、課題となっています。これを解決するための技術の開発も進められています。AIは優れた技術ですが、現在のAIには、作業適性と応用する仕事の内容を熟慮したうえで人と仕事を分担する、適材適所での配置が大切です。

2020年3月公開

- PROFILE

伊藤 元昭氏

伊藤 元昭氏

株式会社 エンライト 代表- 技術者として3年間の半導体開発、日経マイクロデバイスや日経エレクトロニクス、日経BP半導体リサーチなどの記者・デスク・編集長として12年間のジャーナリスト活動、コンサルタントとして6年間のメーカー事業支援活動などを経て、2014年に独立して株式会社 エンライトを設立。

-

ポンプの

ポンプの

基礎知識クラス

移送に関する基本情報を

わかりやすくコンパクトに

解説していきます。- 【A-1a】ポンプの種類

- 【A-1b】ポンプの種類(容積式ポンプ)

- 【A-2】ポンプの原理

- 【A-3a】軸封装置

- 【A-3b】軸封装置(メカニカルシール)

- 【A-3c】軸封装置(グランドパッキン)

- 【A-4a】NPSH(Ⅰ)

- 【A-4b】NPSH(Ⅱ)

- 【A-5】ウォーターハンマー

- 【A-6a】ポンプ選定時に確認すべき事項(1)

- 【A-6b】ポンプ選定時に確認すべき事項(2)

- 【A-6c】ポンプ選定時に確認すべき事項(3)

- 【A-7a】ポンプに使用される金属材料について

- 【A-7b】ステンレス鋼について

- 【A-7c】ステンレス鋼の腐食形態について

- 【A-7d】ポンプに使用される非鉄金属について

- 【A-8a】ポンプに使用されるゴム材料について

- 【A-8b】ゴム材料の物理的な特性

- 【A-8c】ゴム材料の化学的な特性

- 【A-9a】金属材料への表面処理

-

ポンプの

ポンプの

周辺知識クラス

規格や周辺機器情報などを

解説していきます。- 【B-1a】ポンプの洗浄1

- 【B-1b】ポンプの洗浄2(自動洗浄における洗浄効果の因子)

- 【B-1c】ポンプの洗浄3(SIPとASEPTIC)

- 【B-2a】駆動機(駆動機の概要)

- 【B-2b】駆動機(三相交流かご形誘導モーター)

- 【B-2c】駆動機(保護方式と耐熱クラス)

- 【B-2d】駆動機(モーター技術の動向)

- 【B-2e】駆動機(変速装置・減速装置)

- 【B-2f】駆動機(番外編:周波数)

- 【B-3a】インバーターの基礎知識(Ⅰ)

- 【B-3b】インバーターの基礎知識(Ⅱ)

- 【B-3c】インバーターの基礎知識(Ⅲ)

- 【B-3d】インバーターの基礎知識(Ⅳ)

- 【B-3e】インバーターの基礎知識(Ⅴ)

- 【B-3f】インバーターの基礎知識(Ⅵ)

- 【B-4】防爆

- 【B-5】管材と計測器

- 【B-6】トップランナーモーター

- 【B-7】マグネットカップリング

-

移送物の

移送物の

基礎知識クラス

液の特長や性状および

主な用途などを

解説していきます。 -

IoT・AIで変わる

IoT・AIで変わる

「送る&運ぶ」

移送・搬送の現場がIoT化、

AI(人工知能)活用で

どのように変わるのか。

伊藤元昭氏が解説します。- 第1回:産業機器のIoT化で何が変わるか

- 第2回:IoTは、日本のものづくり企業こそ活用すべき

- 第3回:AI活用の本質は、匠の技やベテランの知恵の機械化

- 第4回:AI活用を円滑・効果的に進めるための鍵は現場力にあり

- 第5回:AIの「ブラックボックス問題」との付き合い方

- 第6回:5Gで加速する工場・プラントでのIoT活用

- 第7回:ものづくりのDXで、現場の仕事はどう変わるのか?①

- 第8回:ものづくりのDXで、現場の仕事はどう変わるのか?②

- 第9回:協働ロボットで作る、人と機械が助け合う現場

- 第10回:コロナ禍で加速した、ものづくりでのAI/IoT活用

- 第11回:IoT/AIを駆使して対応する脱炭素時代のものづくり

- 第12回:製造業での脱炭素化、最初に始めたいこととは

- 第13回:サプライチェーンの管理は見える化から自律化へ

- 第14回:パブリックな仮想世界、メタバースは製造業に何をもたらすのか

- 第15回:メタバース上のバーチャルファクトリーで、多方面の専門家が密に協業

- 第16回:リチウムイオン二次電池から全固体電池へ、実現の鍵を握る技術「MI」

- 第17回:電極・電解質・イオン種、全方位で進化し続ける二次電池

- 第18回:スマホや自動運転車の技術転用で、産業機器や働くクルマの自律化を実現

- 第19回:再エネ主力電源化時代が到来、大口需要家である工場に求められる備えとは

- 第20回:メンテナンス業務を再定義する、IoT遠隔監視システム

- 第21回:生成AI活用で加速する、製造業での自動設計と新素材開発

-

現場の声で、

現場の声で、

ひとくふう

モーノポンプの使い方は現場によりさまざま。

ひとくふうを加えると、

実はおもしろい発見が!